Sora模型视频生成操作全解析

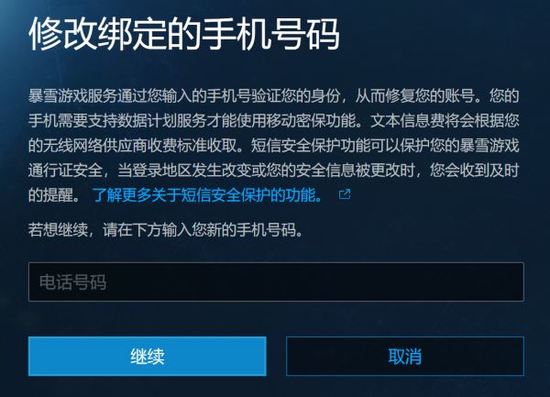

Sora模型如何实现视频创作当用户需要进行视频内容制作时,可先对目标画面进行精准文字描述。输入框内需完整表述场景构成、角色特征、动态效果及氛围基调等要素,系统支持通过右侧参数面板调整视频分辨率与时长设定。确认文本描述与自定义配置后,点击生成按钮即可启动AI运算流程。

智能文生视频系统操作详解

在视频内容构思阶段,建议采用分层描述法逐项说明视觉要素。主体场景需明确时空背景与环境特征,角色设定应包含外貌特征与行为轨迹,动态效果需标注关键帧运动规律。系统通过语义解析引擎将文字信息转化为三维空间坐标,配合物理引擎模拟真实运动轨迹。

视频生成过程中,系统采用分阶段渲染技术。首阶段建立基础场景框架,第二阶段加载动态元素与光影效果,最终阶段进行画面降噪与细节优化。处理时长与视频复杂度正相关,4K规格的60秒视频平均需要8-12分钟生成时间。

用户可随时中断生成进程进行画面修正,系统支持局部重绘与全局参数调整。通过时间轴编辑器可单独修改特定帧画面,修改后的内容将自动进行前后帧过渡优化,确保视频流畅度。

该系统集成了九大核心算法模块,包含空间拓扑建模、时序预测、材质渲染等关键技术。通过混合式神经网络架构,可同时处理图像语义理解与运动轨迹预测双重任务。

视频生成原理基于改进型扩散模型,初始阶段生成高噪点视频雏形,经过32轮迭代降噪后输出清晰画面。采用分块式处理技术,将视频分解为256个独立单元并行运算,显著提升生成效率。

模型架构融合Transformer注意力机制与三维卷积网络优势,通过DALL-E 3视觉编码器实现精准的图文匹配。训练数据集包含超过2亿个标注视频片段,涵盖5000余种物理运动模式。

针对长视频生成难题,系统采用记忆增强型生成策略。通过建立场景状态数据库,持续跟踪画面元素的空间关系与运动轨迹,有效解决传统模型存在的帧间断裂问题。

当前版本在物理仿真方面仍存在优化空间,特别是在流体动力学模拟与复杂碰撞检测场景中,可能出现运动轨迹偏差。研发团队正在集成强化学习模块以提升物理引擎精度。

技术突破体现在时域一致性控制方面,通过引入时间卷积核对连续帧进行关联分析,使得60秒视频的画面连贯性达到专业级制作水准。该系统现已支持1080P至8K多种分辨率输出。

本教程详细解析了智能视频生成系统的操作流程与技术特性,用户可通过官方渠道获取最新版本应用程序。持续关注系统更新日志可及时获取新增功能与性能优化信息。