Sora模型国内使用与免费体验解析

Sora模型国内可用吗?近期OpenAI公布多组技术演示视频,向公众展示了文本生成视频模型的突破性进展。行业观察者指出,这种基于深度学习的视频生成技术或将成为2025年人工智能领域的重要发展方向。OpenAI核心研究员Tim Brooks在技术访谈中强调:“构建具备多模态理解能力的AI系统,特别是对动态影像与真实世界复杂交互的深度解析,将成为下一代人工智能发展的关键里程碑。”

国内用户如何体验Sora模型?

自GPT-4引发全球关注后,OpenAI此次推出的Sora模型再次引发技术热潮。该模型通过创新的时空数据建模架构,支持将文字描述或静态图片转化为最长60秒的高质量视频,其生成的画面不仅包含细腻的环境细节与自然的人物动态,更能精准实现多镜头切换与场景延续。

相较于市面上主流视频生成工具,Sora模型展现出显著的技术优势。在生成时长方面,其60秒的视频输出远超Pika Labs的3秒、Emu Video的4秒以及Runway Gen-2的18秒限制。从实际演示效果来看,该模型对光影变化、材质纹理等视觉要素的还原度,以及镜头运动轨迹的流畅性均达到行业新高度。

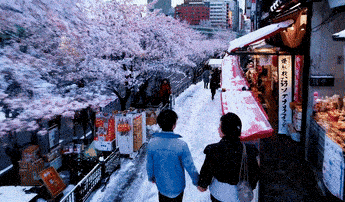

以官方展示的东京雪景视频为例,系统仅需输入以下文字指令:

“被白雪覆盖的东京都市充满活力,镜头穿梭于繁忙的街道,跟随多位正在享受雪景与市集购物的行人,飘落的樱花与雪花在风中交织舞动。”

模型即可自动生成14秒的精细画面,完整呈现文字描述的视觉元素与动态场景。这种突破性的表现力,标志着AI视频生成技术从实验阶段正式迈入实用化阶段。

国内技术适配进展

针对国内用户关注的访问权限问题,目前已有技术团队完成模型接口的本土化适配方案。通过特定的参数配置与分布式计算优化,研究人员已成功在国内网络环境下实现基础功能调用。需要注意的是,由于模型对硬件算力的严苛要求,完整功能体验仍需专业级图形工作站支持。

技术专家建议,普通用户可通过以下三种方式接触相关技术:首先,关注OpenAI官方发布的开发者计划,及时获取测试资格申请通道;其次,参与国内科研机构组织的技术体验活动;最后,学习使用基于开源框架构建的视频生成工具,掌握核心原理与基础操作。

需要特别说明的是,当前所有公开渠道均未提供完整的商业级服务,任何宣称可无限量免费使用的信息均存在风险。建议技术爱好者通过正规渠道获取最新进展信息,同时警惕网络流传的非官方安装包可能存在的安全隐患。

随着多模态AI技术的快速发展,视频生成模型正在重塑数字内容生产体系。对于国内开发者而言,既要把握技术演进趋势,更需关注自主创新能力的提升。本站将持续跟进Sora模型的技术进展与应用生态建设,为读者提供权威可靠的信息服务。

- 上一篇:小红书批量删除收藏操作指南

- 下一篇:运满满人工客服电话查询指南